阿里云GPU服务器:丰富的GPU卡,快速部署ai大模型

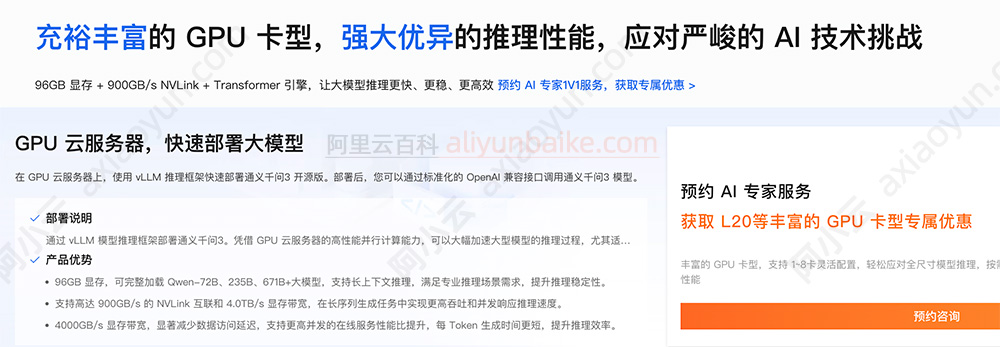

阿里云GPU云服务器提供丰富的GPU卡,快速部署大模型,GPU算力提供强大优异的推理性能,96GB显存、900GB/s NVLink和Transformer引擎,帮助用户的AI大模型推理更快更稳且高效,阿里云GPU服务器官方活动入口:https://t.aliyun.com/U/tbBeAi 如下图:

在GPU云服务器上,使用vLLM推理框架快速部署通义千问3开源版。部署后,用户可以通过标准化的OpenAI兼容接口调用通义千问3模型。

部署说明:通过vLLM模型推理框架部署通义千问3。凭借GPU云服务器的高性能并行计算能力,可以大幅加速大型模型的推理过程,尤其适用于处理大规模数据集和高并发请求场景,从而显著提升推理速度与吞吐量。

GPU云服务器优势:

- 96GB显存,可完整加载Qwen-72B、235B、671B+大模型,支持长上下文推理,满足专业推理场景需求,提升推理稳定性。

- 支持高达900GB/s的NVLink互联和4.0TB/s显存带宽,在长序列生成任务中实现更高吞吐和并发响应推理速度。

- 4000GB/s显存带宽,显著减少数据访问延迟,支持更高并发的在线服务性能比提升,每Token生成时间更短,提升推理效率。

AI时代的GPU云服务器,L20 GPU实例gn8ia规格可用于搜索推荐,GPU云服务器gn8v实例可用于模型推理,更多关于阿里云GPU服务器的说明,请移步到官方页面查看:atengyun.com/go/gpu

腾讯云服务器特价:https://curl.qcloud.com/oRMoSucP

阿里云服务器优惠:https://t.aliyun.com/U/bLynLC